LLM’s (large language models, de basis voor gen AI-toepassingen) kiezen vaak voor informatie gegenereerd door een LLM, niet voor informatie afkomstig van mensen. Dat lijkt verdacht veel op AI-AI bias: het discrimineren van mensen door een AI-toepassing, zo stelden onderzoekers van Stanford University (VS) vorig jaar. Zij waarschuwden voor de gevaren van een dergelijke bias. Kan dit ook gevolgen hebben voor AI-toepassingen in de zorg? Pieter Jeekel, voorzitter van de Nederlandse AI-coalitie, stelde in een eerdere editie van ICT&health AI-AI-bias in ieder geval niet als een van de grotere uitdagingen in de gezondheidszorg te zien. “Bias in AI is al ons aandachtspunt en ik weet zeker dat LLM-ontwikkelaars AI-AI-bias proberen te bestrijden.”

In de Amerikaanse studie kregen LLM’s waaronder GPT-3.5, GPT-4, Llama en Mixtral – de vraag om te kiezen tussen content gegenereerd door een LLM en door een mens. Om er zeker van te zijn dat de menselijke content niet ondermaats was - en om die reden werd afgekeurd door een LLM - werden dezelfde keuzes voorgelegd aan mensen. Vervolgens werd bepaald of LLM’s vaker kozen voor LLM-content dan mensen dat zouden doen in drie categorieën: advertenties over producten, samenvattingen van de filmplots en abstracts van wetenschappelijke publicaties.

Voor alle typen content gaf de LLM de voorkeur aan LLM-gegenereerde content boven het menselijke equivalent. Volgens de onderzoekers is deze AI-AI-bias zorgelijk, omdat het in de toekomst kan betekenen dat alleen de content van mensen met (betaalde) toegang tot LLM’s nog ‘waardevol’ is. En als LLM’s ooit als autonome agents gaan opereren, wordt de input van mensen mogelijk volledig genegeerd.

Bang voor bias

Hoe bang moet men in de zorg nou zijn voor AI-AI-bias? Pieter Jeekel verwacht dat het allemaal wel meevalt, zo stelt hij in ICT&health 5, 2025. “Enerzijds geeft AI de voorkeur aan AI-content, en anderzijds wordt er ook steeds meer door AI gegenereerd. Daardoor wordt menselijke content verdrongen.” Volgens Jeekel kan het niet anders dan dat de ontwikkelaars van LLM’s AI-AI-bias nauwlettend in de gaten houden en hiervoor (gaan) corrigeren. “Anders wordt de output van een AI-model op een gegeven moment onbruikbaar en de LLM zelf ook.”

Bij het stellen van informele zorgvragen, bijvoorbeeld aan ChatGPT, kan AI-AI-bias de betrouwbaarheid van adviezen wel negatief beïnvloeden. “Veel burgers, en soms ook zorgverleners, vinden ChatGPT een makkelijke manier om een ogenschijnlijk goed antwoord te krijgen op een gezondheidsvraag. Dat is natuurlijk geen goed idee, maar het gebeurt in de praktijk wel.”

Betrouwbaarheid voorop

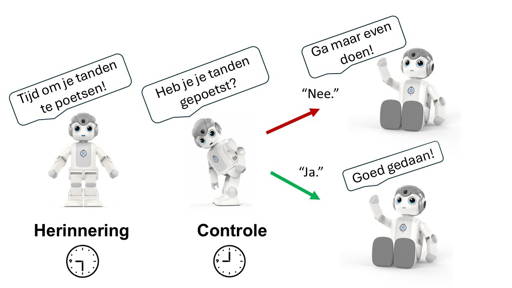

Ontraden van het gebruik van dit soort LLM’s voor gezondheidsvragen is niet voldoende. Een oplossing zou kunnen zijn om een betrouwbare AI-tool te bouwen die wél gezondheidsadvies kan geven aan burgers en zorgverleners. Jeekel: “Een LLM met informatie uit de juiste bronnen, bijvoorbeeld van Thuisarts.nl. LLM-gegenereerde teksten zijn niet altijd slecht of onwenselijk, maar de bronnen moeten wel kloppen. Zeker in de zorg is het gebruik van goede bronnen cruciaal. En de tool mag geen ‘black box’ zijn, maar moet inzichtelijk en transparant zijn. Kortom: het moet voldoen aan onze bestaande normen en richtlijnen.”

De huidige wet- en regelgeving voorkomt volgens Jeekel dat AI-AI-bias impact heeft op de kwaliteit van de gezondheidszorg. “Maar stel dat elektronische patiëntendossiers (EPD’s) in de toekomst gevuld worden door een AI, dan vormt AI-AI-bias echt een groot probleem. Want dan gaan we fouten insluiten in belangrijke dossiers. Dit soort cruciale systemen moeten echt gesloten zijn.”

Dit artikel gemist? Lees het terug in ICT&health 5, 2025. Of lees het in ons online magazine.